随着数据量的爆炸式增长,大数据治理已成为企业数字化转型的核心支柱。一个全面的大数据治理整体解决方案,不仅涉及战略、组织与流程,更关键的是对数据处理环节的精细化设计与高效执行。数据处理作为数据从原始状态转化为高价值资产的枢纽,其质量、效率与安全性直接决定了数据治理的成败。

数据处理的核心目标与挑战

数据处理的核心目标是确保数据在采集、存储、加工、分析和应用的全生命周期中,保持准确性、一致性、时效性与安全性。企业在实践中常面临诸多挑战:数据来源多样且格式不一,导致整合困难;数据处理流程复杂,易形成数据孤岛;数据质量参差不齐,影响分析结果的可信度;数据安全与隐私合规要求日益严格,处理不当可能引发法律风险。

数据处理的关键组件与策略

一个成熟的数据处理解决方案应包含以下关键组件与策略:

- 数据集成与采集:采用ETL(抽取、转换、加载)或ELT(抽取、加载、转换)工具,实现多源异构数据的实时或批量集成。通过API接口、日志收集、物联网设备接入等方式,确保数据采集的全面性与及时性。

- 数据清洗与标准化:建立数据质量规则库,自动检测并修复数据中的错误、缺失与重复问题。制定统一的数据标准(如编码、命名规范),消除语义歧义,提升数据一致性。

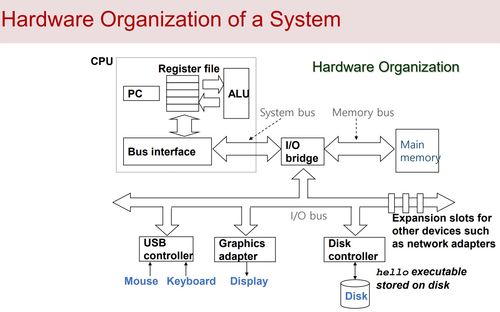

- 数据存储与管理:基于数据湖或数据仓库架构,结合分布式存储技术(如Hadoop HDFS、云存储),实现结构化与非结构化数据的高效存储。通过元数据管理,记录数据的来源、变换过程与使用情况,增强数据可追溯性。

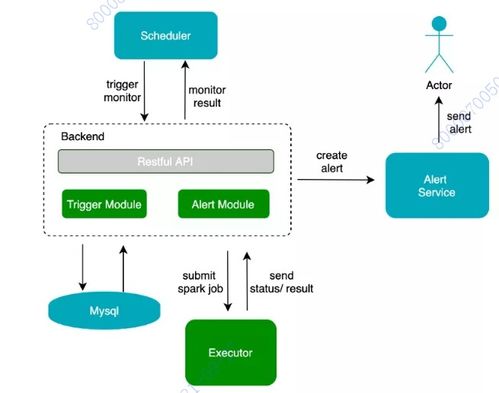

- 数据加工与计算:利用批处理(如Spark)和流处理(如Flink)引擎,对数据进行聚合、关联与深度分析。引入机器学习模型,实现数据智能化处理,例如异常检测与自动分类。

- 数据安全与合规:实施数据分级分类,对敏感信息进行加密、脱敏或匿名化处理。建立访问控制机制,确保数据仅在授权范围内使用。遵循GDPR等法规,满足数据隐私保护要求。

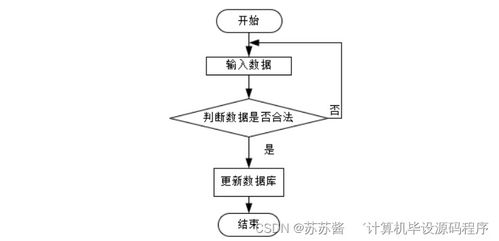

- 数据处理流程自动化:通过工作流调度工具(如Airflow),将数据处理任务流程化、自动化,减少人工干预,提高处理效率与可靠性。

实践建议与未来展望

企业在构建数据处理方案时,应优先明确业务需求,避免技术驱动的盲目投入。建议从小规模试点开始,逐步迭代扩展,同时培养跨部门的数据治理团队,确保技术与业务的深度融合。随着人工智能与边缘计算的发展,未来的数据处理将更加智能化与实时化,企业需持续优化架构,以应对日益复杂的数据环境。

数据处理是大数据治理整体解决方案的基石。只有通过系统化的策略与工具,将原始数据转化为可信、可用的资产,企业才能真正释放数据价值,驱动创新与增长。